|

Größe: 1044

Kommentar:

|

Größe: 1814

Kommentar:

|

| Gelöschter Text ist auf diese Art markiert. | Hinzugefügter Text ist auf diese Art markiert. |

| Zeile 2: | Zeile 2: |

| Auf cogito (KI-Server) läuft ein [[https://ollama.com|Ollama]]-server, der einen OpenAI-API kompatiblen Endpunkt bereitstellt. Er ist unter https://buero.ping.de:11434/ erreichbar, man benötigt für den Zugriff ein Bearer Token. |

|

| Zeile 3: | Zeile 5: |

| 1. Im Brave Browser oben rechts auf das "Leo AI" Icon klicken (sieht aus wie ein großer und ein kleiner Stern) | 1. Im Brave Browser oben rechts auf das "Leo AI" Icon {{attachment:Brave Leo AI Icon.png|Brave Leo AI Icon.png}} klicken. |

| Zeile 9: | Zeile 11: |

| * Modellanfragename: `qwen3:30b-a3b-q8_0` (diesen Namen seht ihr so auch im open-webui) | * Modellanfragename: `qwen3:30b-a3b-q8_0` (diesen Namen seht ihr so auch im open-webui oder s.u.) |

| Zeile 11: | Zeile 13: |

| * Kontext-Größe: `8192` * API-Schlüssel: Siehe Punkt 1. Ohne "Bearer" davor eingeben. |

* Kontext-Größe: `8192` (mehr geht auch, hängt vom LLM und freien VRAM ab). * API-Schlüssel: Siehe Punkt 1. Ohne "Bearer" davor eingeben.<<BR>> {{attachment:Brave Leo AI config.png|Brave Leo AI config.png}} |

| Zeile 16: | Zeile 18: |

| Fertig. Wenn ihr jetzt auf den Leo-AI-Icon klickt startet eine neue Unterhaltung mit dem LLM auf dem PING Server cogito. | Fertig. Wenn ihr jetzt auf das Leo-AI-Icon klickt startet eine neue Unterhaltung mit dem LLM auf dem PING Server cogito. == Verfügbare Modelle auflisten == Wenn ihr eine Liste aller installierten Modelle sehen möchtet, dann könnt ihr das entweder in [[https://buero.ping.de|open-webui]] oder es geht über die Ollama API wie folgt (ihr benötigt die Befehle `curl` und `jq`): {{{ BEARER_TOKEN=bitte_erfragen curl -sH "Authorization: Bearer $BEARER_TOKEN" https://buero.ping.de:11434/api/tags | jq }}} |

Konfigurieren von Leo AI im Brave Browser mit dem PING AI Server

Auf cogito (KI-Server) läuft ein Ollama-server, der einen OpenAI-API kompatiblen Endpunkt bereitstellt. Er ist unter https://buero.ping.de:11434/ erreichbar, man benötigt für den Zugriff ein Bearer Token.

- Besorgt euch das Bearer Token

Im Brave Browser oben rechts auf das "Leo AI" Icon

klicken.

klicken. - Klickt oben rechts auf die 3 Punkte übereinander "⋮"

Klickt ganz unten auf "Erweiterte Einstellungen" (mit dem Zahnrad). Ihr landet dann auf brave://settings/leo-ai

- Unter "Bringen Sie Ihr eigenes Modell mit" klickt auf "Neues Modell hinzufügen"

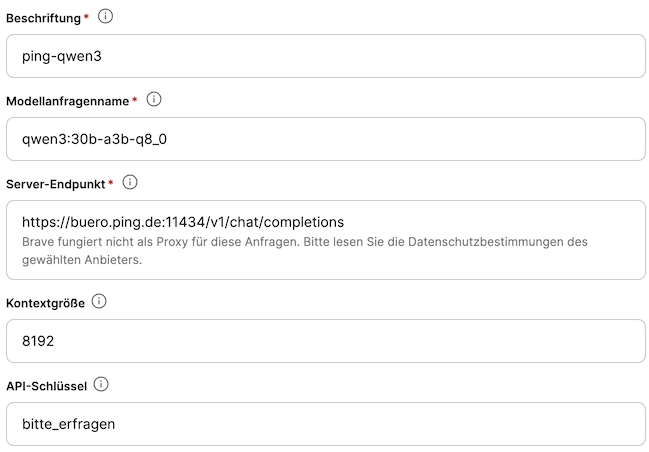

- Macht folgende Einstellungen:

Beschriftung: ping-qwen3

Modellanfragename: qwen3:30b-a3b-q8_0 (diesen Namen seht ihr so auch im open-webui oder s.u.)

Server-Endpunkt: https://buero.ping.de:11434/v1/chat/completions

Kontext-Größe: 8192 (mehr geht auch, hängt vom LLM und freien VRAM ab).

API-Schlüssel: Siehe Punkt 1. Ohne "Bearer" davor eingeben.

- Klickt auf "Modell speichern"

Stellt das "Standardmodell für neue Unterhaltungen" auf ping-qwen3

Fertig. Wenn ihr jetzt auf das Leo-AI-Icon klickt startet eine neue Unterhaltung mit dem LLM auf dem PING Server cogito.

Verfügbare Modelle auflisten

Wenn ihr eine Liste aller installierten Modelle sehen möchtet, dann könnt ihr das entweder in open-webui oder es geht über die Ollama API wie folgt (ihr benötigt die Befehle curl und jq):

BEARER_TOKEN=bitte_erfragen curl -sH "Authorization: Bearer $BEARER_TOKEN" https://buero.ping.de:11434/api/tags | jq