|

Größe: 421

Kommentar:

|

← Revision 19 vom 2026-01-09 19:05:06 ⇥

Größe: 3561

Kommentar:

|

| Gelöschter Text ist auf diese Art markiert. | Hinzugefügter Text ist auf diese Art markiert. |

| Zeile 1: | Zeile 1: |

| = Cline Plugin, Visual Studio Code und der PING KI Server = 1. In VS Code das Cline Plugin installieren. Achtet darauf dass es das blaue Checkmark hat: . {{attachment:cline1.png}} |

## page was renamed from Anleitungen/Ollama-VSCode-Cline = Visual Studio Code und OpenCode = Wie nutzt ihr Visual Studio Code und OpenCode mit dem PING KI Server? |

| Zeile 6: | Zeile 5: |

| Zunächst braucht ihr das Bearer Token. Das könnt ihr derzeit bei `weiterbildung` erfragen. Dann geht es wie folgt: | |

| Zeile 7: | Zeile 7: |

| 1. ''How will you use Cline?'' "'''Bring my own API key'''" |

== Visual Studio Code == === Cline Plugin === 1. In VS Code das [[https://cline.bot/|Cline]] Plugin installieren. Achtet darauf dass es das blaue Checkmark hat: . {{attachment:cline1.png}} 1. ''How will you use Cline?'' "'''Bring my own API key'''" |

| Zeile 11: | Zeile 15: |

| 1. Custom base URL: `https://buero.ping.de:11434` |

1. Custom base URL: `https://buero.ping.de:11434` |

| Zeile 15: | Zeile 18: |

| 1. Model: `qwen3-coder:30b` |

1. Model: `devstral-small-2:24b-instruct-25112-q8_0` Fertig! === Kilo Code Plugin === 1. In VS Code das [[https://kilo.ai/|Kilo Code AI Agent]] Plugin installieren. Achtet darauf dass ihr kein falsches erwischt. Aktuell sieht es etwa so aus: . {{attachment:kilo code vs code.png|kilo code vs code.png}} 1. Wählt "Use your own API key" 1. API Provider: Ollama 1. Base URL: `https://buero.ping.de:11434` 1. API Key: '''bitte_erfragen''' 1. Model Name: `devstral-small-2:24b-instruct-25112-q8_0` Fertig! === Continue Plugin === Installiert das [[https://docs.continue.dev/|Continue]] Plugin in VS Code. {{attachment:continue vs code.png|continue vs code.png}} Nehmt folgende Config Datei. Tragt dort den API Key ein in der letzten Zeile. {{{ name: Local Config version: 1.0.0 schema: v1 models: - name: qwen3-coder provider: ollama model: qwen3-coder:30b-a3b-q8_0 apiBase: https://buero.ping.de:11434 roles: - chat - autocomplete - edit - apply - summarize defaultCompletionOptions: contextLength: 65000 requestOptions: headers: Authorization: Bearer bitte_erfragen }}} == OpenCode == Für OpenCode müsst ihr eine `opencode.json` Datei anlegen z.B. im Verzeichnis `~/.config/opencode/` Ermittelt welche Modelle der Server anbietet, die euch fürs Programmieren interessieren: {{{ BEARER_TOKEN=bitte_erfragen curl -sH "Authorization: Bearer $BEARER_TOKEN" https://buero.ping.de:11434/api/tags|jq -r '.models[]|"\(.name)\t\t\((.size/1024/1024/1024*10|floor)/10) GB"' }}} Aktueller Output: (2026-01): {{{ qwen3-coder:30b-a3b-q8_0 30.2 GB devstral-small-2:24b-instruct-2512-q8_0 24.1 GB nemotron-3-nano:30b-a3b-q8_0 31.2 GB qwen3:30b-a3b-instruct-2507-q8_0 30.2 GB gpt-oss:latest 12.8 GB nomic-embed-text:latest 0.2 GB gemma3:27b-it-q8_0 27.5 GB }}} Dann tragt die Modelle in die opencode.json Datei ein, in etwa wie so: {{{ { "$schema": "https://opencode.ai/config.json", "provider": { "ollama": { "npm": "@ai-sdk/openai-compatible", "name": "Ollama (PING)", "options": { "baseURL": "https://buero.ping.de:11434/v1" }, "models": { "devstral-small-2:24b-instruct-2512-q8_0": { "name": "Devstral-Small-2 2512" }, "qwen3-coder:30b-a3b-q8_0": { "name": "Qwen3-Coder 30B A3B Q8" }, "gpt-oss:latest": { "name": "GPT-OSS 20B" } } } } } }}} Wenn ihr das nächste Mal OpenCode startet und /connect tippt könnt ihr nach "PING" suchen und solltet den Eintrag "Ollama (PING)" angezeigt bekommen. Wenn euch dann das OpenCode nach dem API Key fragt, gibt bitte das Bearer Token ein, das ihr erfragen müsst. |

Visual Studio Code und OpenCode

Wie nutzt ihr Visual Studio Code und OpenCode mit dem PING KI Server?

Zunächst braucht ihr das Bearer Token. Das könnt ihr derzeit bei weiterbildung erfragen. Dann geht es wie folgt:

Visual Studio Code

Cline Plugin

In VS Code das Cline Plugin installieren. Achtet darauf dass es das blaue Checkmark hat:

How will you use Cline? "Bring my own API key"

API Provider: Ollama

Custom base URL: https://buero.ping.de:11434

Ollama API key: bitte_erfragen

Model: devstral-small-2:24b-instruct-25112-q8_0

Fertig!

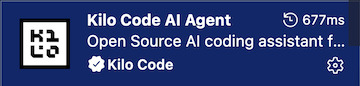

Kilo Code Plugin

In VS Code das Kilo Code AI Agent Plugin installieren. Achtet darauf dass ihr kein falsches erwischt. Aktuell sieht es etwa so aus:

- Wählt "Use your own API key"

- API Provider: Ollama

Base URL: https://buero.ping.de:11434

API Key: bitte_erfragen

Model Name: devstral-small-2:24b-instruct-25112-q8_0

Fertig!

Continue Plugin

Installiert das Continue Plugin in VS Code.

Nehmt folgende Config Datei. Tragt dort den API Key ein in der letzten Zeile.

name: Local Config

version: 1.0.0

schema: v1

models:

- name: qwen3-coder

provider: ollama

model: qwen3-coder:30b-a3b-q8_0

apiBase: https://buero.ping.de:11434

roles:

- chat

- autocomplete

- edit

- apply

- summarize

defaultCompletionOptions:

contextLength: 65000

requestOptions:

headers:

Authorization: Bearer bitte_erfragen

OpenCode

Für OpenCode müsst ihr eine opencode.json Datei anlegen z.B. im Verzeichnis ~/.config/opencode/

Ermittelt welche Modelle der Server anbietet, die euch fürs Programmieren interessieren:

BEARER_TOKEN=bitte_erfragen curl -sH "Authorization: Bearer $BEARER_TOKEN" https://buero.ping.de:11434/api/tags|jq -r '.models[]|"\(.name)\t\t\((.size/1024/1024/1024*10|floor)/10) GB"'

Aktueller Output: (2026-01):

qwen3-coder:30b-a3b-q8_0 30.2 GB devstral-small-2:24b-instruct-2512-q8_0 24.1 GB nemotron-3-nano:30b-a3b-q8_0 31.2 GB qwen3:30b-a3b-instruct-2507-q8_0 30.2 GB gpt-oss:latest 12.8 GB nomic-embed-text:latest 0.2 GB gemma3:27b-it-q8_0 27.5 GB

Dann tragt die Modelle in die opencode.json Datei ein, in etwa wie so:

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"ollama": {

"npm": "@ai-sdk/openai-compatible",

"name": "Ollama (PING)",

"options": {

"baseURL": "https://buero.ping.de:11434/v1"

},

"models": {

"devstral-small-2:24b-instruct-2512-q8_0": {

"name": "Devstral-Small-2 2512"

},

"qwen3-coder:30b-a3b-q8_0": {

"name": "Qwen3-Coder 30B A3B Q8"

},

"gpt-oss:latest": {

"name": "GPT-OSS 20B"

}

}

}

}

}Wenn ihr das nächste Mal OpenCode startet und /connect tippt könnt ihr nach "PING" suchen und solltet den Eintrag "Ollama (PING)" angezeigt bekommen. Wenn euch dann das OpenCode nach dem API Key fragt, gibt bitte das Bearer Token ein, das ihr erfragen müsst.